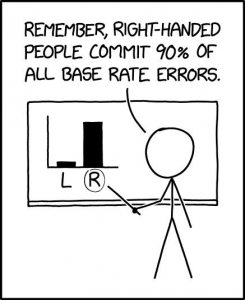

Adverse impact ist der negative Effekt, den ein unfaires und voreingenommenes Auswahlverfahren (z.B. ein Eignungstest) auf eine Minderheit relativ zur Mehrheitsgesellschaft hat. In den USA werden sie als protected groups bezeichnet anhand von Merkmalen, die im Zusammenhang mit gesetzlichen Regelungen gegen Diskriminierung gebräuchlich sind. Für amerikanische Organisationen gilt für solche geschützten Gruppen während eines Auswahlverfahrens – wie einer Einstellungs- oder Beförderungsentscheidung – die Vier/Fünftel-Regel als gesetzliche Notwendigkeit gegen Diskriminierung.

Ähnliche Regeln stehen künftig auch allen europäischen Anbietern bevor, wenn die ersten Klagen bis zur höchsten Instanz des EuGH geklettert sein werden. Vor allem, wenn die Initiativen der entsprechenden Communities verstanden haben, was Empowerment bewirken kann auf dem Rechtsweg. Die „Industrie“ der Eignungsdiagnostik in Deutschland ist weitgehend ahnungs- und/oder planlos bei diesem Thema. Man versucht sich selbst einzureden, IQ-Tests seien kulturfair bzw. -invariant. Die Untätigkeit auf allen Seiten widerspricht der internationalen Forschungslage:

Untersuchungen aus den USA und Ländern wie z.B. den Niederlanden (De Meijer et al., 2006) zeigen, dass untersuchte Minoritätsgruppen gegenüber Majoritätsgruppen sowohl in kognitiven Fähigkeitstests (Roth et al., 2001), in Tests zu sprachlichen Fertigkeiten (Hough et al., 2001), in Auswahlinterviews (Roth et al., 2002) als auch in Assessment Centern (Dean et al., 2008) in der Regel schlechter abschneiden. Dieses Muster findet sich auch in dem Auswahlprozess der untersuchten deutschen Behörde. Quelle: Stumpf et al., 2016

Was soll die 4/5-Regel?

Für bestimmte Merkmale bzw. Bevölkerungsgruppen wird eine negative Auswirkung anhand der Vier-Fünftel- oder Achtzig-Prozent-Regel ermittelt. Diese Regel wird in den amerikanischen Richtlinien erklärt: „Eine Auswahlquote für eine Rasse, ein Geschlecht oder eine ethnische Gruppe, die weniger als vier Fünftel (oder 80 %) der Quote für die Mehrheitsgruppe beträgt, wird von den US-Bundesvollzugsbehörden im Allgemeinen als Beweis für eine nachteilige Auswirkung betrachtet, während eine Quote von mehr als vier Fünfteln von den Bundesvollzugsbehörden im Allgemeinen nicht als Beweis für eine nachteilige Auswirkung betrachtet wird.“ Das heißt, die Selektionsrate (also die tatsächlich eingestellten Bewerber) von Gruppen mit bestimmter Religionszugehörigkeit, Geschlecht, Alter, sexueller Orientierung etc. darf 80 Prozent der Gruppe mit der höchsten Selektionsrate nicht unterschreiten. Andernfalls hat das Auswahlverfahren einen „Adverse Impact“ und ist diskriminierend. Wenn also in einem Unternehmen 300 Busfahrende eingestellt sind, und davon 100 christliche, männliche Busfahrer, dann müssen auch mindestens 80 weibliche sowie 80 mit anderer Religionszugehörigkeit dort Busse fahren.

In dem Präzedenzfall Griggs versus Duke Power verklagten Willie Griggs und zwölf weitere afroamerikanische Angestellte der Firma Duke Power ihren Arbeitgeber mit der Behauptung, dass der allgemeine Intelligenztest, den Duke als Screening-Instrument verwendete, afroamerikanische Bewerber ungerechtfertigt benachteiligte. 58 Prozent der Weißen kamen durch den Test, aber nur 6 Prozent der People of Color. Dazu urteilte der Oberste Gerichtshof (Supreme Court): Wenn Tests vor der Einstellung eine ungleiche Auswirkung auf geschützte Gruppen (wie Frauen und ethnische Minderheiten) hätten, die Organisation, die den Test verlangt, nachweisen muss, dass der Test in einem „angemessenen Verhältnis“ zu den auf der Stelle ausgeführten Aufgaben steht.

Im Fall von Duke Power betrug die Auswahlrate von Afroamerikanern besagte sechs Prozent, während die Auswahlrate von Weißen jedoch 58 % betrug. Dividiert man die niedrigste Auswahlrate (6 %) durch die höhere (58 %), erhält man 6/58 = 10,3 %: deutlich unter dem gesetzlichen Minimum von 80 %. Da der 80%-Test keine Wahrscheinlichkeitsverteilungen beinhaltet, um festzustellen, ob die Ungleichheit ein „nicht zufälliges“ Ereignis ist, wird er normalerweise nicht als definitiver Test für nachteilige Auswirkungen angesehen. Alternative werden statistische Signifikanztests, wie die Analyse der Standardabweichung, für diesen Zweck verwendet.

In der Praxis bedeutete dies, dass die meisten Anbieter von Eignungstests entweder:

- Erhebliche Verbesserung beim spezifischen Bezug zu den Arbeitsaufgaben ihrer Tests benötigen;

- ihre Tests modifizieren müssen, um das Potenzial für nachteilige Auswirkungen zu beseitigen;

- oder beides.

Spezialisten für Eignungsdiagnostik warten erstmal proaktiv ab…

Spezialisten für Eignungsdiagnostik warten erstmal proaktiv ab…

Bei der Phalanx der deutschen Spezialisten für Eignungsdisagnostik nimmt man das Problem nicht ernst, dass viele ihrer Eignungstests nicht kulturfair oder kulturinvariant sein könnten. Denn es wurden noch nicht mal die klassischen statistischen Verfahren angewandt, um die Messinvarianz zwischen Gruppen in klassischen Statistikprogrammen wie MPlus, AMOS oder RStudio auf Ebene der Messmodelle zu prüfen. Dass einige Personaler, die internationale oder amerikanische Fachkonferenzen besuchen, dieses Problem kennen, müsste den Anbietern eigentlich Grund genug sein, tätig zu werden. Vielleicht fehlt die statistische Grundkompetenz oder der Wille. Vor allem aber das Wissen über wesentliche Merkmale geschützter Gruppen und die Auswirkungen auf Testverfahren sind nicht erkennbar. Und dass, obwohl psychologische Experten auf allen Seiten mit der Community Psychology einen eigenen Fachbereich zur Verfügung hätten, der dieses Themenfeld seit Jahren forschend begleitet. Leider hat in Deutschland nur die FernUniversität in Hagen ein eigenes Lehrgebiet zum Thema. Dort ist sehr viel Expertise zu methodischen und praktischen Fragen rund um Diversität. Leider wird sie kaum abgerufen.

Und was machen die Anbieter so?

Für Kunden und deren Diversitätsbestrebungen tun Anbieter aktuell gar nichts; und damit auch nichts für geschützte Gruppen. Das ist besonders tragisch bei öffentlichen Verwaltungen , die oft proaktiv das Thema Diskriminierung angehen. Es gibt seit 2016 sogar eine akademisch publizierte, jedoch enttäuschende Einschätzung eines behördlichen Tests der Polizei (hier: Wiener Testsystem). Aber auch beim niedersächsischen Innenministerium konnte man zeigen, dass sprachbasierte Tests, die oft mehr als die Hälfte der Eigungstests für Behörden umfassen, Nachteile für bestimmte Gruppe begründen: Beim Prüfen des dort eingesetzten Eignungstests im Jahr 2007 ergaben Analysen, dass der Test auch veraltete Wörter abprüft, die bestimmte soziokulturelle Milieus eher nicht kennen. Denn Begriffe wie „Gesinde“, „Docht“ oder „Spelunke“ sind für Bewerberbende mit Migrationshintergrund weitgehend unbekannt. 2009 wurde das Problem etwas gemildert. Aber das Validitätsdilemma der hohen Spreizung zwischen verschiedenen geschützten Gruppen bleibt bestehen, vor allem auch bei den vermeintlich kulturfairen kognitiven Tests, also allen logikbasierten Aufgaben (de Soete et al,, 2013). Die Mehrheit der Verwaltungen von der kleinen Kommune bis zu Bundesministerien arbeitet seit Jahrzehnten mit demselben Anbieter für Eignungstests: der Deutschen Gesellschaft für Personalwesen. Dort hat man trotz Digitalisierung und Diversität offenbar viel Zeit. Man portierte 2020 den dreistündigen Eignungstest von der Papierversion auf handliche Tablets, die die Testleiter in Zukunft statt der Papierstapel austeilen. Keine Online-Tests? Doch, die gibt es dort auch. Manche Kommunen buchen deren webbasierten Kurztest als Online-Verfahren, bisher nur zur Vorselektion, um nur bestimmte Personen zum Haupttest einzuladen.

“ Dabei sind die Leistungsunterschiede der ethnischen Subgruppen in den in einer frühen Selektionsphase eingesetzten Testverfahren zur Messung der kognitiven Fähigkeiten und der Rechtschreibung am größten. “ (Stumpf et al., 2016)

Neben der potentielle Diskriminierung geschützter Gruppen gibt es aber handfestere Problem bezogen auf die Hauptzielgruppe: Denn statt mentaler Leistung will man bei den Jugendlichen immer noch eher Geduld, Gehorsam und Aufmerksamkeit testen als mentale Fähigkeiten. Ab einer Testlänge von einer Stunde misst man einen steigenden Teil Aufmerksamkeit statt Intelligenz. Und das bei Schulabgängern! Obwohl eine gewichtete Durchschnittsnote über die letzten Schuljahre in den Hauptfächern als Langzeitindikator der bessere Prädiktor für spätere berufliche Leistung ist, denn sie sagt zusätzlich zur mentalen Leistung etwas über Fleiß, soziale Kompetenz und Relationen aus . Es macht also wenig Sinn, Bewerber für die ein aktueller Langzeitwert im Bewerbermanagement vorliegen könnte (sie müssten nur für die Hauptfächer der letzten Schuljahre Noten abfragen und gewichtet mitteln). Warum sollte man diese Gruppe für den mittleren und gehobenen Dienst zusätzlich auf Intelligenz testen? Alle relevanten Signale sind schon vorhanden.

Es sei denn, man plant systematisch, überdurchschnittlich intelligente neue Mitarbeitende in Routinetätigkeit zu unterfordern. Denn tägliche Routinearbeit und Intelligenz korrelieren stark negativ, genauso wie Wohlbefinden und Arbeitszufriedenheit. Die Folgen kann man in jedem Heft zum Thema betriebliches Gesundheitsmanagement lesen. Testökonomisch moderne adaptive Tests, wie die Fachwelt – unter anderem die Bundesagentur – sie seit vielen Jahren erfolgreich einsetzt, sind dort ferne Zukunft. Diversität könnte dann deren nächster Evolutionsschritt werden…ab dem Jahr 2030. Leider ist dort zusätzlich das Problem virulent, dass Subtests an aktuellen Bewerbern validiert werden, also an einer Gruppe, die nicht die gesamte Bevölkerung repräsentiert, weil sich nicht alle bei Behörden bewerben und dort nicht alle zum Test eingeladen werden. Forschende bezeichnen das Problem als Stichprobenfehler. Das ist aus akademischer Sicht ein K.O.-Kriterium für Eignungstests. Das bedeutet, dass bei der dgp die Probleme viel grundlegenderer, methodischer Natur sind als der hier besschriebene Kontext.

Aber auch bekante Konkurrenten wie eligo, die beim Testen online schon ein Stückchen weiter sind, publizieren zum Thema diskriminierungsfreies Testen von arbeitsbezogenen Merkmalen, Fähigkeiten und Fertigkeiten nichts Relevantes. In deren Produktbeschreibungen enthält jeder Subtest die schwammige Formel“ Vorbehaltlich anderslautender empirischer Befunde, kann davon ausgegangen werden, dass die hier benutzten Subtests faire Verfahren sind.“ Sie leiten das theoretisch her, prüfen aber gar nicht statistisch ihre Tests – entgegen anderslautender Erfahrungen in der internationalen Forschendencommunity. Die Kunden müssten wohl die Subtests von eligo einzeln auf Gruppeninvarianz testen. Aber sie haben gar keinen Zugang. Eine Blackbox mit schwammigen Versprechungen, dass man was ändert, wenn jemand einen Fehler findet. Da niemand prüfenden Zugang hat, findet niemand einen Fehler. Sie kennen das Verfahren von anderen fragwürdigen Produkten.

Ähnlich wird es bei Schuhfried und auch Hogrefe sein, die ja nur eingekaufte Testverfahren externe Testentwickler zur Verfügung stellen. Offenbar gibt es bei den Anbietern niemanden, der dieser Forschendenzunft angehört bzw. nicht an internationalen Symposien und Konferenzen teilnimmt. Das verstört besonders bei beiden Letztgenannten, da deren Zulieferer (die Testentwickler) nicht selten Lehrstühle an Universitäten inne haben. Aber auf die universitäre Psychologie kommen wir noch weiter unten…

Zurück zum Testen von Schulabgängern. Aktuell ist noch nicht mal die kognitive Kontrolle – oder angesichts von stundenlangen Tests – die Aufmerksamkeit im Fokus der Anbieter als konfundierende Variable. Beides sind offenbar Konstrukte, die große Anteile an den Resultaten solcher Tests haben. Ob und mit welchen beruflichen Kompetenzen und Leistungen sie korrelieren, sollte ihnen wichtig sein. Denn ihre Kunden haben ein Recht zu erfahren, was da überhaupt gemessen wird und ob das mit den spezifischen Anforderungsprofilen oder den Zielen der Firma vereinbar ist.

MBTI, DISG und andere Typentests

Psychologen und Personalspezialsten anderer Disziplinen haben jahrzehntelang versucht, Menschen in Typen einzuteilen. Es gibt viele Verfahren, die sich auf C.G. Jung berufen. Keines der typenbasierten Verfahren erfüllt wissenschaftlichen Standards an Reliabiltät (Messgenauigkeit) oder Validität (Gültigkeit des Messkriteriums). Personaler können weiter diese Verfahren für Personalauswahl nutzen. Denselben Erfolg werden sie jedoch mit Tarotkarten oder Kaffesatzlesen erzielen und deutlich günstiger fahren. Es besteht bei den Tests also keine Gefahr irgendjemanden zu benachteiligen – außer den Personalverantwortlichen selbst. Mehr dazu auf Youtube im Video von Prof. Kanning.

Was bisher geschah

Als besonders negatives Beispiel für die desatröse Unkenntnis und Fehleinschätzung der gesamten Problematik kann man das Paper der Psychologen Kersting und Ott (2015) von der Universität Gießen lesen. Eine Anhäufung von Stammtisch-Spekulationen mit sehr wenig oder ganz ohne Bezüge zu aktueller Forschung werden zu einem Text komponiert, der Lesende ratlos zurücklässt. Textprobe: „Vorurteile kommen vor allem bei Informationsmangel zum Tragen. Eignungsdiagnostik wirkt daher grundsätzlich einer stereotypen Beurteilung entgegen, weil im Rahmen der Eignungsdiagnostik systematisch und zielorientiert Informationen gesammelt werden. Insbesondere wenn mehrere, unterschiedliche Methoden gleichsinnig einen bestimmten Eindruck bestätigen, fällt es schwer, an einem Vorurteil fest zu halten.“ Das klingt eher religös inspiriert: man hofft das Beste! Vor allem vor dem Hintergund, dass zu dem Zeitpunkt schon belegt war, dass viele Verfahren systematisch diskriminierten. Aber auch Interventionen zum Abbau von Vorurteilen werden in einem Satz kurz gestriffen. Offenbar hatte man den Absatz doch ein zweites Mal gelesen und den enthaltenen Sprengstoff verstanden. Die breite Forschungsliteratur (siehe die zitierten Arbeiten bei Stumpf et al., 2016) oder gar Metaanalysen zu dieser Einschätzung wurden gar nicht erwähnt. Und man verrennt sich dann auch noch in das Lieblingskind der Beraterszene: das Anforderungsprofil: „Ein wichtiges eignungsdiagnostisches Prinzip ist die Anforderungsorientierung. Sofern die Anforderungen nicht stereotyp beschrieben werden, sondern tatsächliche Informationen über die Tätigkeit beinhalten, reduziert die Anforderungsorientierung grundsätzlich stereotype Beurteilungen.“ Diese kühne Behauptung wurde nicht belegt. Das ist nicht verwunderlich. Denn diese Behauptungen belegen den mangelnden Kenntnisstand hinreichend. Hätten die Autoren zu Beginn ihren Untersuchungsgegenstand statt auf Personalauswahl allgemein auf das mittlerweile antike Verfahren des Assessment Centers (AC) beschränkt, wäre das zwar zu kurz gesprungen und immer noch hoch spekulativ, aber nicht grundsätzlich falsch gewesen. Vierzehn Zeilen zum Thema Ethnien und Personalauswahl und eine Metanalyse aus 1998 mit dem Hinweis auf geringe Effekte zugunsten Weißer in den USA sind im Jahr 2015 deutlich unterhalb durchschnittlicher Maßstäbe für akademische Qualität. Sie hätten die Arbeit von de Soete und Kollegen (2013) kennen müssen oder zumindest das dort beschriebene Diversitäts-Validitäts-Dilemma.

Ich wünsche den Personalverantwortlichen eine gute Hand bei der Auswahl von „Experten“. Sie werden sie bei Soziologen, Psychologen, Sozialpädagogen, Kultur- und Sozialwissenschaftlern finden, die sich mit den Auswirkungen von Tests auf geschützte Gruppen auskennen. Vor allem aber sollten diese Experten statistische Verfahren zum Nachweis anführen und nicht wie Kersting und Ott auf ominöse Interventionen für die Durchführenden von ACs verweisen oder darauf wie schwer es einem Beurteilenden wohl fallen mag, Bewerbende neutral zu beurteilen. Vielleicht hätten die Psychologen aus Gießen vorher besser die DIN 33430 gelesen. Uns wäre ein überflüssiger Text erspart geblieben.

Als abschreckendes Schlusswort soll ein weiterer Absatz der Psychologen Kersting und Ott (2015) dienen, der mich fassungslos macht. Offenbar versteht nicht jeder auf Anhieb, welche Gruppen des Schutzes bedürfen und wer für den Schutz verantwortlich ist:“Begreift man Eignungsbeurteilungen als soziale Kognitionen [sic] erübrigt sich auch die Unterstellung, die Personalverantwortlichen würden „absichtlich“ bestimmte Gruppen diskriminieren, beispielsweise in Gestalt eines „old boy network“, welches gezielt die Karriere von Frauen verhindert. Prozesse der Kategorisierung laufen blitzschnell und automatisch ab, etwaige Fehlurteile lassen sich als „unconscious bias“ auffassen.“

Man kann 2021 kaum davon absehen, dass Kahnemanns zitierte Studien zum implicit bias und dem IAT-Test sowie die tausendfach abgehaltenen zugehörigen Diversity-Trainings wenig bis keine Evidenz zeigen, und diese Inhalte eigentlich nicht mehr in neueren Auflagen seines Buch gehören, wie er selber sagt. 2015 wäre zumindet ein Hinweis nötig gewesen, dass psychologische Forschung schon sehr viel weiter war als Kersting und Ott mit diesem Absatz insinuieren. Eine bösartige und abwertende Bedeutung des Absatzes kann man beiden Autoren unterstellen angesichts der Forschungen von Virginia E. Schein seit den 70er Jahren des letzten Jahrhunderts, die 1996 im treffenden Titel gipfelte Think Manager- Think Male: a global phenomenon? Ein Phänomen, das damals und heute nicht nur in der Welt der Manager sondern noch immer und eben auch unter Wissenschaftlern und nicht nur in Gießen weit verbreitet zu sein scheint, wie eine neue Publikation im Journal of Applied Soical Psychology zeigt.

Epilog

Das erinnert mich an 2018 und den Fall Amazon und deren Problem mit Maschinellem Lernen: Man hatte die Software als erste Lernmenge mit Daten erfolgreicher Mitarbeiter gefüttert. Mit dem Ergebnis, dass die künstliche Intelligenz aufgrund von Ähnlichkeiten – musterhafte Korrelationen – mit bereits eingestellten Amazon-Mitarbeitenden (hauptsächlich Männer), systematisch Frauen aus dem Bewerbendenkreis aussortierte. Mit Kersting und Ott könnte man mit tiefer Überzeugung sagen, dass man unabsichtlich Fehlurteile in Kauf genommen hätte, aber die beteiligten Personaler und Beisitzer in ACs zu Diversity-Trainings animieren würde. Verschweigen würde man, dass man absichtlich die Ergebnisse der Verfahren nicht auf Gerechtigkeit überprüfe. So wie das bisher alle oben genannten konstant getan haben.

Weiterführende Literatur:

Chen et al. (2019) Testing a Cognitive Control Model of Human Intelligence

De Soete, B., Lievens, F., & Druart, C. (2013). Strategies for dealing with the diversity-validity dilemma in personnel selection: Where are we and where should we go? Journal of Work and Organizational Psychology, 29(1), 3–12. https://doi.org/10.5093/tr2013a2

Weitere Lektüre aus den Medien:

https://www.spektrum.de/magazin/wie-kulturfair-sind-iq-tests/1871470 (paywal)

Mögliche Ursachen für Unterschiede im Überblick:

https://socialsci.libretexts.org/Bookshelves/Sociology/Introduction_to_Sociology/Book%3A_Sociology_(Boundless)/13%3A_Education/13.05%3A_The_Conflict_Perspective_on_Education/13.5E%3A_Tilting_the_Tests-_Discrimination_by_IQ

1 Gedanke zu „Eignungstests & Diversity: Wann kommt die 4/5-Regel zur Bewerberauswahl in Europa an?“

Die Kommentare sind geschlossen.